生成AIの動向と活用技術

「生成AIパスポート(2026年版シラバス対応)」の中で、第3章はこういう役割です。

第2章で「生成AIの仕組み(なぜ文章や画像を作れるのか)」を学んだあと、

第3章では一気に現実の世界へ降りてきます。

- 今のAIで何ができるの?

- 仕事や生活で、どう使うのが上手いの?

- 便利な反面、どんな危険があるの?

つまりこの章は、生成AIを「知識」ではなく、道具として安全に使いこなすための実践編です。

2026年2月試験向けの最新シラバスでは、特に次の4点が柱になっています。

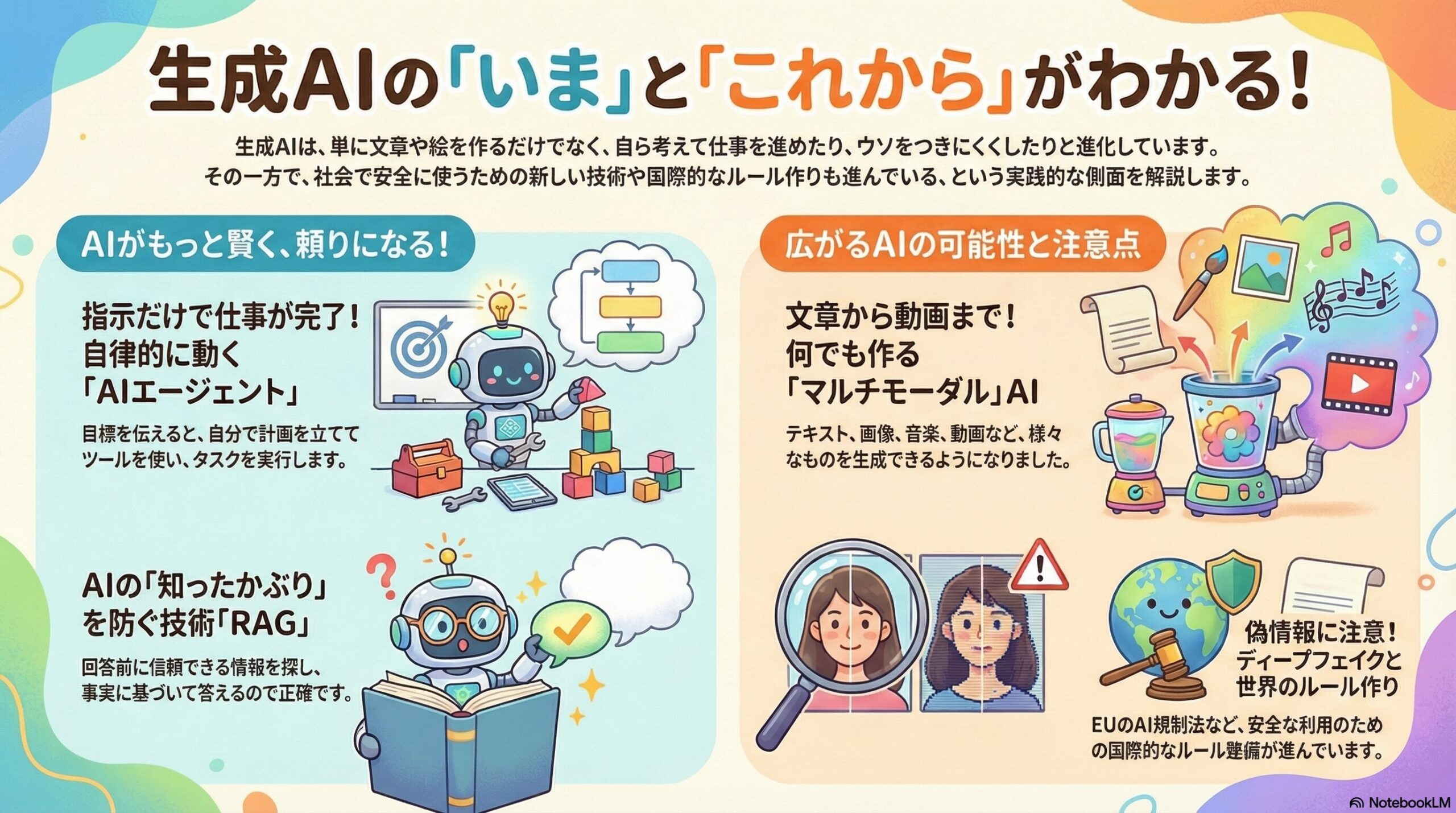

1. 「作るAI」から「やってくれるAI」へ:AIエージェント

これまでの生成AIは、基本的に「質問したら答える」タイプでした。

でも最近は、AIが自分で作業を進める方向へ進化しています。

AIエージェントって何?

一言でいうと、指示を受けたら、段取りを考えて、作業を実行するAIです。

たとえば、

- 「このテーマを調べて、要点をまとめて、メール案を作って」

- 「旅行プランを作って、予約候補を出して」

- 「会議メモを整理して、ToDoリストを作って」

みたいに、ゴールを渡すとAIが

「まず調べる→整理する→文章にする」

のように、自分で順序を組んで動きます。

MCPって何?(やさしく)

AIエージェントが動くためには、AIが外部の道具を使える必要があります。

たとえば「カレンダー」「メール」「検索」「社内ツール」など。

そのときに登場するのが MCP(Model Context Protocol) で、

ざっくり言うと AIと外部ツールをつなぐ“共通の接続ルール” です。

最新シラバスでは、GenSpark、Manusなどの例も学習対象になっていて、

AIが「相談相手」から「仕事を進める実務者」に近づいていることが強調されています。

2. AIの“もっともらしいウソ”を減らす:RAG(検索拡張生成)

生成AIは便利ですが、弱点もあります。

それが ハルシネーション。初心者さん向けに言うと、

AIが、確かめずに「それっぽい答え」を作ってしまうこと

です。しかも自信満々で言うのが厄介。

そこで重要になるのがRAG

**RAG(検索拡張生成)**は、

AIが答える前に、外部の信頼できる情報を探して、その内容をもとに答えを作る仕組みです。

たとえば、

- 社内規程

- 最新ニュース

- 製品マニュアル

- 法令や公的資料

を検索して、根拠を取り込んでから回答するので、ウソが減りやすくなります。

仕組みを支える用語も登場

RAGの説明で出てくる用語は、初心者には最初ちょっと硬いけど、意味はシンプル。

- チャンク:文書を「意味のかたまり」に小さく分けたもの

(長文をそのまま渡すと扱いにくいので、適度なサイズに切るイメージ) - ベクトルデータベース:文章を「意味で探せるように保存する箱」

(キーワード一致じゃなく、近い意味の情報も見つけやすくする)

3. 文字だけじゃない:画像・音声・動画まで広がる(マルチモーダル)

今の生成AIは、文章を作るだけではありません。

最近は、

- 画像を作る・直す

- 音声で会話する

- 音楽を作る

- 動画を作る

といった方向へ広がっています。

マルチモーダルって何?

テキスト以外も扱えるAIのことです。

「文章+画像」「文章+音声」のように、複数の形式をまとめて処理できます。

シラバスには、Gemini、Claude、Sora、Veo3、Luma Dream Machineなど、

主流ツールの名前も出てきて、「今どんなサービスが中心か」も押さえる流れになっています。

画像生成を支える“下ごしらえ”

生成AIは、材料(データ)の質が結果を左右します。そこで出てくるのが次の考え方です。

- リサイズ:画像の大きさをそろえる

- 正規化:データの数値の範囲を整える(学習しやすくする)

- データ拡張(augmentation):画像を回転・反転などして、学習用データを増やす

料理で言うなら、食材を洗って切って、調理しやすくする下準備みたいなものだね。

4. 便利さの裏にある危険:偽情報・偏見・ルールの話

技術が強くなるほど、「悪用」や「事故」も増えます。

第3章は、そのリスクにもちゃんと目を向けます。

ディープフェイク(深層偽造)

AIで作った偽の映像や音声が、本物みたいに見える問題です。

これが広がると、偽情報(ディスインフォメーション)が社会に混乱を起こします。

倫理の問題

- 学習データに偏りがあると、AIの判断にも偏りが出る(差別・偏見)

- AIの判断理由が説明できない(ブラックボックス問題)

そこで重要になるのが

**XAI(説明可能なAI)**です。

これは「AIがなぜそう判断したかを説明できるようにする」考え方です。

世界のルール作り

AIの開発競争が激しい一方で、

EUのAI規制法案など、安全に使うための法律や国際ルールも整えられつつあります。

「技術だけでなく、社会の仕組みもセットで動いている」という視点がポイントです。

まとめ:第3章は「実務に持ち込むための設計図とルールブック」

第3章が伝えたいことは、これに尽きます。

生成AIは強力な道具。

だからこそ “使い方” と “安全策” と “社会ルール” をセットで学ぶ必要がある。

たとえるなら、

- 生成AIという高性能エンジンを手に入れたあと

- AIエージェントやRAGで「安全に動く車」に仕立て

- 倫理や法律という交通ルールを守って社会で走らせる

そのための設計図とルールブックが、この章です。🚗💨