情報リテラシーと法規制

「生成AIパスポート(2026年2月試験対応)」の中で第4章は、

AIの仕組みや使い方を学んだ先にある、

- 社会的な責任

- 法的なリスク管理

を扱う章です。

生成AIは非常に強力な道具ですが、使い方を誤ると

情報漏えい、権利侵害、詐欺被害、炎上といった問題を引き起こす可能性があります。

この章は、そうした事態を防ぐための実践的な知識を整理したものです。

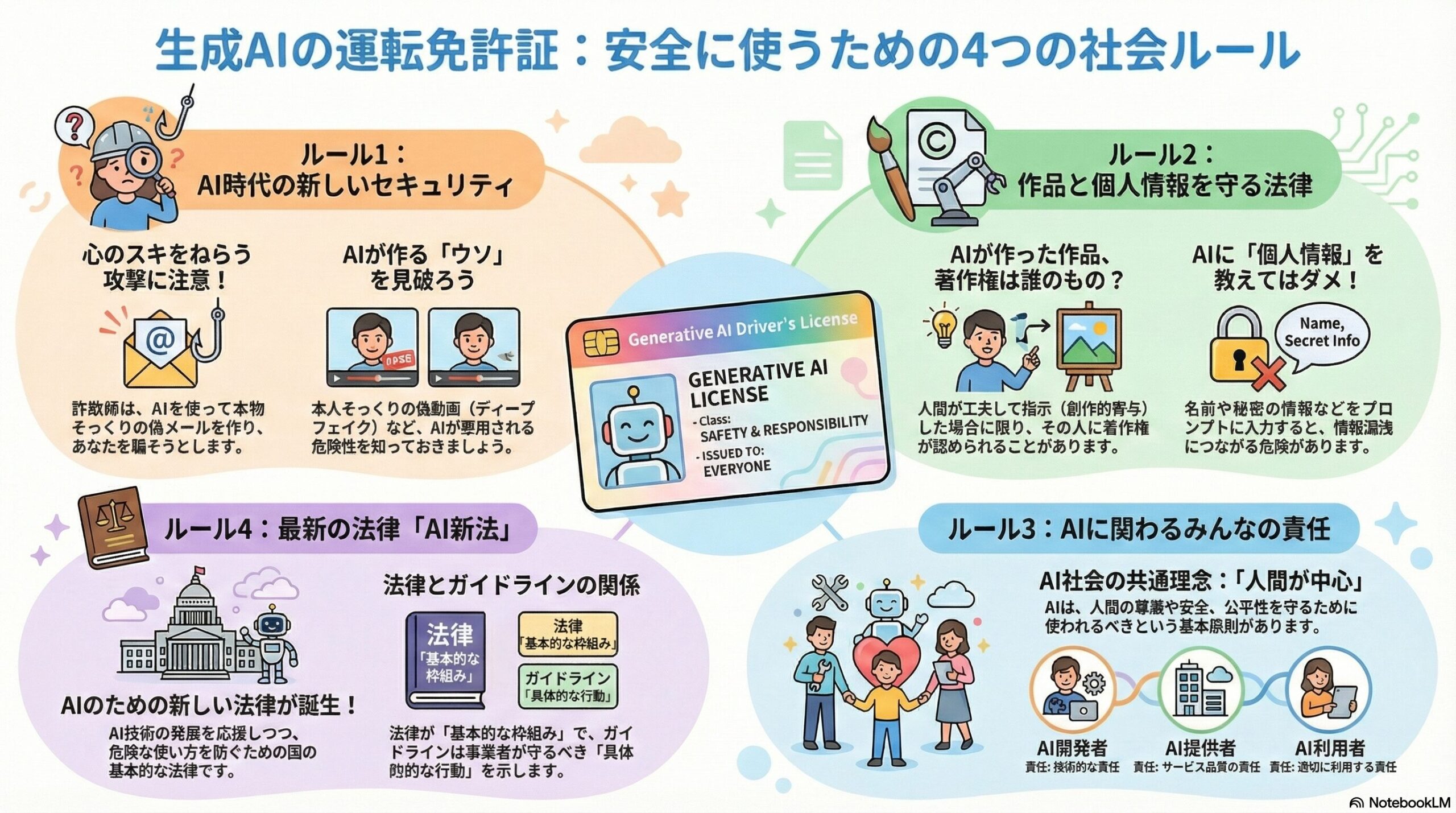

1) AI時代の新しいセキュリティと情報リテラシー

狙われるのは「システム」よりも「人」

生成AIの普及により、インターネット上の脅威はより巧妙になっています。

特に注意すべきなのは、技術的な脆弱性だけでなく、人の心理を突く攻撃です。

ソーシャルエンジニアリングとは

これは、相手をだまして情報を引き出す手法の総称です。

- フィッシング:正規サービスを装ったメールやサイトで情報を盗む

- スピアフィッシング:特定の企業や個人を狙って作られた精巧な詐欺

- ベイト攻撃:「重要資料」「請求書」など、興味を引く内容で誘導する手口

生成AIが関係するリスク

生成AIが悪用されると、

- 不自然さのない詐欺メール

- 実在しそうな社内連絡文

- ディープフェイク(偽の音声・画像・動画)

が容易に作られるようになります。

そのため、情報の内容や出所を見極める情報リテラシーが重要になります。

2) 「制作物」と「個人情報」を守るための法的な考え方

実務でAIを利用する際、特に注意が必要なのが

知的財産権(著作権など)と個人情報の取り扱いです。

A. 知的財産権・著作権

AIが生成したコンテンツについては、次の考え方が基本になります。

- AIが自動的に生成しただけのものは、原則として著作権が認められにくい

- 一方で、人が明確な意図を持ち、内容に工夫や判断を加えている場合

(=創作意図と創作的寄与がある場合)

著作物として扱われる可能性があります

重要なのは、

生成された内容が既存の作品やブランドを侵害していないかを確認する責任は、人間側にあるという点です。

AIを使ったからといって、責任までAIに移るわけではありません。

B. 個人情報の取り扱い

生成AIへの入力内容によっては、

個人情報保護法や契約上の問題が生じる可能性があります。

特に注意が必要なのは、

- 実名、連絡先、住所など個人を特定できる情報

- 社内資料や未公開情報

- 要配慮個人情報(健康、病歴、思想信条など)

これらを扱う際は、必要最小限にとどめる、内容を抽象化するなどの配慮が求められます。

3) AIガバナンスと「3つの主体」の責任

AIを安全に運用するためには、個人の注意だけでなく、

組織としての管理体制、つまりAIガバナンスが重要になります。

この章では、関係者を次の3つに分けて整理しています。

- AI開発者:AIそのものを設計・開発する立場

- AI提供者:AIをサービスとして提供する立場

- AI利用者:業務や実務でAIを活用する立場

それぞれが役割と責任を持つことで、リスクを分散し、事故を防ぎます。

また、AI社会において共有されるべき基本的な考え方として、

- 人間中心

- 安全性・公平性

- 透明性

- 説明責任(アカウンタビリティ)

といった原則が示されています。

4) 2026年試験で重要となる「AI新法」とガイドライン

今回のシラバス改訂では、最新の法整備への対応が重視されています。

- AI新法

AIの研究開発と活用を推進しつつ、適正な利用を確保するための法的枠組み - AI事業者ガイドラインの改訂

実務におけるリスクや対応を、より具体的に示した指針

法律は大枠のルール、ガイドラインは現場での運用指針、

この関係性を押さえておくと理解しやすくなります。

まとめ:第4章は「AIを社会で使うための必須知識」

第4章が伝えているのは、次の一点です。

生成AIは便利で強力だからこそ、

技術と同時に、責任・ルール・配慮を学ぶ必要がある。

たとえるなら、

- 生成AI:高性能な車

- この章:免許、交通ルール、保険に相当する知識

運転技術だけでは安全は保てません。

この章は、AIを社会の中で使い続けるための基盤を整える役割を果たしています。